リンク・アグリゲーション¶

本章では、Ryuを用いたリンク・アグリゲーション機能の実装方法を解説していきます。

リンク・アグリゲーション¶

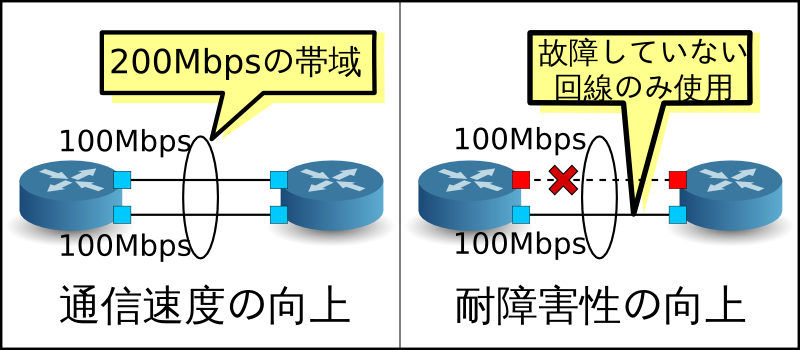

リンク・アグリゲーションは、IEEE802.1AX-2008で規定されている、複数の物理的な回線を束ねてひとつの論理的なリンクとして扱う技術です。リンク・アグリゲーション機能により、特定のネットワーク機器間の通信速度を向上させることができ、また同時に、冗長性を確保することで耐障害性を向上させることができます。

リンク・アグリゲーション機能を使用するには、それぞれのネットワーク機器において、どのインターフェースをどのグループとして束ねるのかという設定を事前に行っておく必要があります。

リンク・アグリゲーション機能を開始する方法には、それぞれのネットワーク機器に対し直接指示を行うスタティックな方法と、LACP(Link Aggregation Control Protocol)というプロトコルを使用することによって動的に開始させるダイナミックな方法があります。

ダイナミックな方法を採用した場合、各ネットワーク機器は対向インターフェース同士でLACPデータユニットを定期的に交換することにより、疎通不可能になっていないことをお互いに確認し続けます。LACPデータユニットの交換が途絶えた場合、故障が発生したものとみなされ、当該ネットワーク機器は使用不可能となり、パケットの送受信は残りのインターフェースによってのみ行われるようになります。この方法には、ネットワーク機器間にメディアコンバータなどの中継装置が存在した場合にも、中継装置の向こう側のリンクダウンを検知することができるというメリットがあります。本章では、LACPを用いたダイナミックなリンク・アグリゲーション機能を取り扱います。

Ryuアプリケーションの実行¶

ソースの説明は後回しにして、まずはRyuのリンク・アグリゲーション・アプリケーションを実行してみます。

このプログラムは、「スイッチングハブ」のスイッチングハブにリンク・アグリゲーション機能を追加したアプリケーションです。

ソース名:simple_switch_lacp_13.py

from ryu.base import app_manager

from ryu.controller import ofp_event

from ryu.controller.handler import CONFIG_DISPATCHER

from ryu.controller.handler import MAIN_DISPATCHER

from ryu.controller.handler import set_ev_cls

from ryu.ofproto import ofproto_v1_3

from ryu.lib import lacplib

from ryu.lib.dpid import str_to_dpid

from ryu.lib.packet import packet

from ryu.lib.packet import ethernet

from ryu.app import simple_switch_13

class SimpleSwitchLacp13(simple_switch_13.SimpleSwitch13):

OFP_VERSIONS = [ofproto_v1_3.OFP_VERSION]

_CONTEXTS = {'lacplib': lacplib.LacpLib}

def __init__(self, *args, **kwargs):

super(SimpleSwitchLacp13, self).__init__(*args, **kwargs)

self.mac_to_port = {}

self._lacp = kwargs['lacplib']

self._lacp.add(

dpid=str_to_dpid('0000000000000001'), ports=[1, 2])

def del_flow(self, datapath, match):

ofproto = datapath.ofproto

parser = datapath.ofproto_parser

mod = parser.OFPFlowMod(datapath=datapath,

command=ofproto.OFPFC_DELETE,

out_port=ofproto.OFPP_ANY,

out_group=ofproto.OFPG_ANY,

match=match)

datapath.send_msg(mod)

@set_ev_cls(lacplib.EventPacketIn, MAIN_DISPATCHER)

def _packet_in_handler(self, ev):

msg = ev.msg

datapath = msg.datapath

ofproto = datapath.ofproto

parser = datapath.ofproto_parser

in_port = msg.match['in_port']

pkt = packet.Packet(msg.data)

eth = pkt.get_protocols(ethernet.ethernet)[0]

dst = eth.dst

src = eth.src

dpid = datapath.id

self.mac_to_port.setdefault(dpid, {})

self.logger.info("packet in %s %s %s %s", dpid, src, dst, in_port)

# learn a mac address to avoid FLOOD next time.

self.mac_to_port[dpid][src] = in_port

if dst in self.mac_to_port[dpid]:

out_port = self.mac_to_port[dpid][dst]

else:

out_port = ofproto.OFPP_FLOOD

actions = [parser.OFPActionOutput(out_port)]

# install a flow to avoid packet_in next time

if out_port != ofproto.OFPP_FLOOD:

match = parser.OFPMatch(in_port=in_port, eth_dst=dst)

self.add_flow(datapath, 1, match, actions)

data = None

if msg.buffer_id == ofproto.OFP_NO_BUFFER:

data = msg.data

out = parser.OFPPacketOut(datapath=datapath, buffer_id=msg.buffer_id,

in_port=in_port, actions=actions, data=data)

datapath.send_msg(out)

@set_ev_cls(lacplib.EventSlaveStateChanged, MAIN_DISPATCHER)

def _slave_state_changed_handler(self, ev):

datapath = ev.datapath

dpid = datapath.id

port_no = ev.port

enabled = ev.enabled

self.logger.info("slave state changed port: %d enabled: %s",

port_no, enabled)

if dpid in self.mac_to_port:

for mac in self.mac_to_port[dpid]:

match = datapath.ofproto_parser.OFPMatch(eth_dst=mac)

self.del_flow(datapath, match)

del self.mac_to_port[dpid]

self.mac_to_port.setdefault(dpid, {})

実験環境の構築¶

OpenFlowスイッチとLinuxホストの間でリンク・アグリゲーションを構成してみましょう。

VMイメージ利用のための環境設定やログイン方法等は「スイッチングハブ」を参照してください。

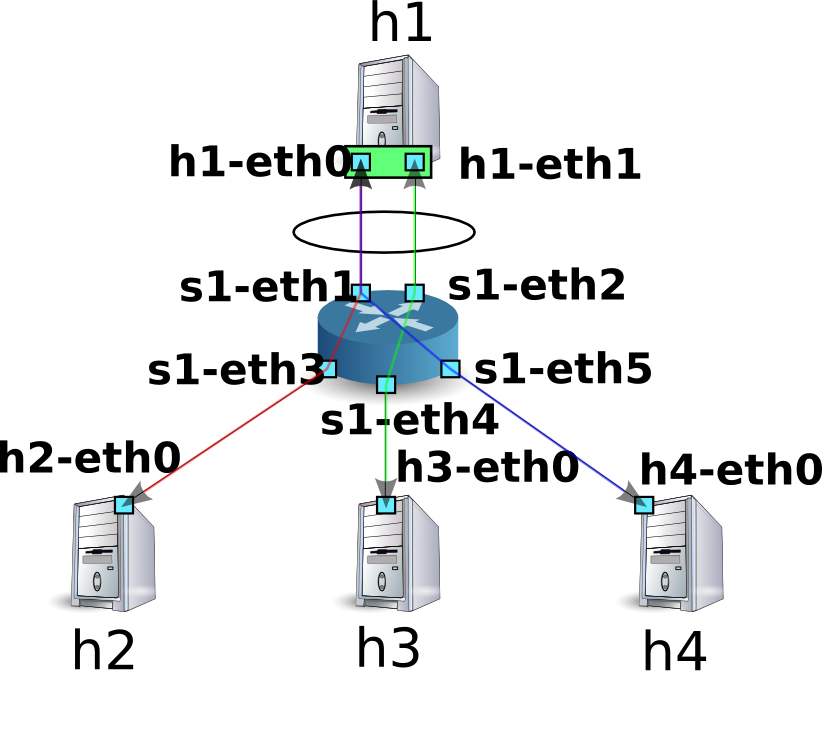

最初にMininetを利用して下図の様なトポロジを作成します。

MininetのAPIを呼び出すスクリプトを作成し、必要なトポロジを構築します。

ソース名:link_aggregation.py

#!/usr/bin/env python

from mininet.cli import CLI

from mininet.net import Mininet

from mininet.node import RemoteController

from mininet.term import makeTerm

if '__main__' == __name__:

net = Mininet(controller=RemoteController)

c0 = net.addController('c0', port=6633)

s1 = net.addSwitch('s1')

h1 = net.addHost('h1')

h2 = net.addHost('h2', mac='00:00:00:00:00:22')

h3 = net.addHost('h3', mac='00:00:00:00:00:23')

h4 = net.addHost('h4', mac='00:00:00:00:00:24')

net.addLink(s1, h1)

net.addLink(s1, h1)

net.addLink(s1, h2)

net.addLink(s1, h3)

net.addLink(s1, h4)

net.build()

c0.start()

s1.start([c0])

net.startTerms()

CLI(net)

net.stop()

このスクリプトを実行することにより、ホストh1とスイッチs1の間に2本のリンクが存在するトポロジが作成されます。netコマンドで作成されたトポロジを確認することができます。

$ curl -O https://raw.githubusercontent.com/osrg/ryu-book/master/sources/link_aggregation.py

$ sudo ./link_aggregation.py

Unable to contact the remote controller at 127.0.0.1:6633

mininet> net

c0

s1 lo: s1-eth1:h1-eth0 s1-eth2:h1-eth1 s1-eth3:h2-eth0 s1-eth4:h3-eth0 s1-eth5:h4-eth0

h1 h1-eth0:s1-eth1 h1-eth1:s1-eth2

h2 h2-eth0:s1-eth3

h3 h3-eth0:s1-eth4

h4 h4-eth0:s1-eth5

mininet>

ホストh1でのリンク・アグリゲーションの設定¶

ホストh1のLinuxに必要な事前設定を行いましょう。本節でのコマンド入力は、ホストh1のxterm上で行ってください。

まず、リンク・アグリゲーションを行うためのドライバモジュールをロードします。Linuxではリンク・アグリゲーション機能をボンディングドライバが担当しています。事前にドライバの設定ファイルを/etc/modprobe.d/bonding.confとして作成しておきます。

ファイル名:/etc/modprobe.d/bonding.conf

alias bond0 bonding

options bonding mode=4

Node: h1:

# modprobe bonding

mode=4はLACPを用いたダイナミックなリンク・アグリゲーションを行うことを表します。デフォルト値であるためここでは設定を省略していますが、LACPデータユニットの交換間隔はSLOW(30秒間隔)、振り分けロジックは宛先MACアドレスを元に行うように設定されています。

続いて、bond0という名前の論理インターフェースを新たに作成します。また、bond0のMACアドレスとして適当な値を設定します。

Node: h1:

# ip link add bond0 type bond

# ip link set bond0 address 02:01:02:03:04:08

作成した論理インターフェースのグループに、h1-eth0とh1-eth1の物理インターフェースを参加させます。このとき、物理インターフェースをダウンさせておく必要があります。また、ランダムに決定された物理インターフェースのMACアドレスをわかりやすい値に書き換えておきます。

Node: h1:

# ip link set h1-eth0 down

# ip link set h1-eth0 address 00:00:00:00:00:11

# ip link set h1-eth0 master bond0

# ip link set h1-eth1 down

# ip link set h1-eth1 address 00:00:00:00:00:12

# ip link set h1-eth1 master bond0

論理インターフェースにIPアドレスを割り当てます。ここでは10.0.0.1を割り当てることにします。また、h1-eth0にIPアドレスが割り当てられているので、これを削除します。

Node: h1:

# ip addr add 10.0.0.1/8 dev bond0

# ip addr del 10.0.0.1/8 dev h1-eth0

最後に、論理インターフェースをアップさせます。

Node: h1:

# ip link set bond0 up

ここで各インターフェースの状態を確認しておきます。

Node: h1:

# ifconfig

bond0 Link encap:Ethernet HWaddr 02:01:02:03:04:08

inet addr:10.0.0.1 Bcast:0.0.0.0 Mask:255.0.0.0

UP BROADCAST RUNNING MASTER MULTICAST MTU:1500 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:10 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:0 (0.0 B) TX bytes:1240 (1.2 KB)

h1-eth0 Link encap:Ethernet HWaddr 02:01:02:03:04:08

UP BROADCAST RUNNING SLAVE MULTICAST MTU:1500 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:5 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:0 (0.0 B) TX bytes:620 (620.0 B)

h1-eth1 Link encap:Ethernet HWaddr 02:01:02:03:04:08

UP BROADCAST RUNNING SLAVE MULTICAST MTU:1500 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:5 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:0 (0.0 B) TX bytes:620 (620.0 B)

lo Link encap:Local Loopback

inet addr:127.0.0.1 Mask:255.0.0.0

UP LOOPBACK RUNNING MTU:16436 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:0 (0.0 B) TX bytes:0 (0.0 B)

論理インターフェースbond0がMASTERに、物理インターフェースh1-eth0とh1-eth1がSLAVEになっていることがわかります。また、bond0、h1-eth0、h1-eth1のMACアドレスがすべて同じものになっていることがわかります。

ボンディングドライバの状態も確認しておきます。

Node: h1:

# cat /proc/net/bonding/bond0

Ethernet Channel Bonding Driver: v3.7.1 (April 27, 2011)

Bonding Mode: IEEE 802.3ad Dynamic link aggregation

Transmit Hash Policy: layer2 (0)

MII Status: up

MII Polling Interval (ms): 100

Up Delay (ms): 0

Down Delay (ms): 0

802.3ad info

LACP rate: slow

Min links: 0

Aggregator selection policy (ad_select): stable

Active Aggregator Info:

Aggregator ID: 1

Number of ports: 1

Actor Key: 33

Partner Key: 1

Partner Mac Address: 00:00:00:00:00:00

Slave Interface: h1-eth0

MII Status: up

Speed: 10000 Mbps

Duplex: full

Link Failure Count: 0

Permanent HW addr: 00:00:00:00:00:11

Aggregator ID: 1

Slave queue ID: 0

Slave Interface: h1-eth1

MII Status: up

Speed: 10000 Mbps

Duplex: full

Link Failure Count: 0

Permanent HW addr: 00:00:00:00:00:12

Aggregator ID: 2

Slave queue ID: 0

LACPデータユニットの交換間隔(LACP rate: slow)や振り分けロジックの設定(Transmit Hash Policy: layer2 (0))が確認できます。また、物理インターフェースh1-eth0とh1-eth1のMACアドレスが確認できます。

以上でホストh1への事前設定は終了です。

OpenFlowバージョンの設定¶

スイッチs1のOpenFlowのバージョンを1.3に設定します。このコマンド入力は、スイッチs1のxterm上で行ってください。

Node: s1:

# ovs-vsctl set Bridge s1 protocols=OpenFlow13

スイッチングハブの実行¶

準備が整ったので、冒頭で作成したRyuアプリケーションを実行します。

ウインドウタイトルが「Node: c0 (root)」となっている xterm から次のコマンドを実行します。

Node: c0:

$ ryu-manager ryu.app.simple_switch_lacp_13

loading app ryu.app.simple_switch_lacp_13

loading app ryu.controller.ofp_handler

instantiating app None of LacpLib

creating context lacplib

instantiating app ryu.controller.ofp_handler of OFPHandler

instantiating app ryu.app.simple_switch_lacp_13 of SimpleSwitchLacp13

...

ホストh1は30秒に1回LACPデータユニットを送信しています。起動してからしばらくすると、スイッチはホストh1からのLACPデータユニットを受信し、動作ログに出力します。

Node: c0:

...

[LACP][INFO] SW=0000000000000001 PORT=1 LACP received.

[LACP][INFO] SW=0000000000000001 PORT=1 the slave i/f has just been up.

[LACP][INFO] SW=0000000000000001 PORT=1 the timeout time has changed.

[LACP][INFO] SW=0000000000000001 PORT=1 LACP sent.

slave state changed port: 1 enabled: True

[LACP][INFO] SW=0000000000000001 PORT=2 LACP received.

[LACP][INFO] SW=0000000000000001 PORT=2 the slave i/f has just been up.

[LACP][INFO] SW=0000000000000001 PORT=2 the timeout time has changed.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP sent.

slave state changed port: 2 enabled: True

...

ログは以下のことを表しています。

LACP received.

LACPデータユニットを受信しました。

the slave i/f has just been up.

無効状態だったポートが有効状態に変更されました。

the timeout time has changed.

LACPデータユニットの無通信監視時間が変更されました(今回の場合、初期状態の0秒からLONG_TIMEOUT_TIMEの90秒に変更されています)。

LACP sent.

応答用のLACPデータユニットを送信しました。

slave state changed ...

LACPライブラリからの

EventSlaveStateChangedイベントをアプリケーションが受信しました(イベントの詳細については後述します)。

スイッチは、ホストh1からLACPデータユニットを受信の都度、応答用LACPデータユニットを送信します。

Node: c0:

...

[LACP][INFO] SW=0000000000000001 PORT=1 LACP received.

[LACP][INFO] SW=0000000000000001 PORT=1 LACP sent.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP received.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP sent.

...

フローエントリを確認してみましょう。

Node: s1:

# ovs-ofctl -O openflow13 dump-flows s1

OFPST_FLOW reply (OF1.3) (xid=0x2):

cookie=0x0, duration=14.565s, table=0, n_packets=1, n_bytes=124, idle_timeout=90, send_flow_rem priority=65535,in_port=2,dl_src=00:00:00:00:00:12,dl_type=0x8809 actions=CONTROLLER:65509

cookie=0x0, duration=14.562s, table=0, n_packets=1, n_bytes=124, idle_timeout=90, send_flow_rem priority=65535,in_port=1,dl_src=00:00:00:00:00:11,dl_type=0x8809 actions=CONTROLLER:65509

cookie=0x0, duration=24.821s, table=0, n_packets=2, n_bytes=248, priority=0 actions=CONTROLLER:65535

スイッチには

- h1のh1-eth1(入力ポートがs1-eth2でMACアドレスが00:00:00:00:00:12)からLACPデータユニット(ethertypeが0x8809)が送られてきたらPacket-Inメッセージを送信する

- h1のh1-eth0(入力ポートがs1-eth1でMACアドレスが00:00:00:00:00:11)からLACPデータユニット(ethertypeが0x8809)が送られてきたらPacket-Inメッセージを送信する

- 「スイッチングハブ」と同様のTable-missフローエントリ

の3つのフローエントリが登録されています。

リンク・アグリゲーション機能の確認¶

通信速度の向上¶

まずはリンク・アグリゲーションによる通信速度の向上を確認します。通信に応じて複数のリンクを使い分ける様子を見てみましょう。

まず、ホストh2からホストh1に対しpingを実行します。

Node: h2:

# ping 10.0.0.1

PING 10.0.0.1 (10.0.0.1) 56(84) bytes of data.

64 bytes from 10.0.0.1: icmp_req=1 ttl=64 time=93.0 ms

64 bytes from 10.0.0.1: icmp_req=2 ttl=64 time=0.266 ms

64 bytes from 10.0.0.1: icmp_req=3 ttl=64 time=0.075 ms

64 bytes from 10.0.0.1: icmp_req=4 ttl=64 time=0.065 ms

...

pingを送信し続けたまま、スイッチs1のフローエントリを確認します。

Node: s1:

# ovs-ofctl -O openflow13 dump-flows s1

OFPST_FLOW reply (OF1.3) (xid=0x2):

cookie=0x0, duration=22.05s, table=0, n_packets=1, n_bytes=124, idle_timeout=90, send_flow_rem priority=65535,in_port=2,dl_src=00:00:00:00:00:12,dl_type=0x8809 actions=CONTROLLER:65509

cookie=0x0, duration=22.046s, table=0, n_packets=1, n_bytes=124, idle_timeout=90, send_flow_rem priority=65535,in_port=1,dl_src=00:00:00:00:00:11,dl_type=0x8809 actions=CONTROLLER:65509

cookie=0x0, duration=33.046s, table=0, n_packets=6, n_bytes=472, priority=0 actions=CONTROLLER:65535

cookie=0x0, duration=3.259s, table=0, n_packets=3, n_bytes=294, priority=1,in_port=3,dl_dst=02:01:02:03:04:08 actions=output:1

cookie=0x0, duration=3.262s, table=0, n_packets=4, n_bytes=392, priority=1,in_port=1,dl_dst=00:00:00:00:00:22 actions=output:3

先ほど確認した時点から、2つのフローエントリが追加されています。durationの値が小さい4番目と5番目のエントリです。

それぞれ、

- 3番ポート(s1-eth3、つまりh2の対向インターフェース)からh1のbond0宛のパケットを受信したら1番ポート(s1-eth1)から出力する

- 1番ポート(s1-eth1)からh2宛のパケットを受信したら3番ポート(s1-eth3)から出力する

というフローエントリです。h2とh1の間の通信にはs1-eth1が使用されていることがわかります。

続いて、ホストh3からホストh1に対しpingを実行します。

Node: h3:

# ping 10.0.0.1

PING 10.0.0.1 (10.0.0.1) 56(84) bytes of data.

64 bytes from 10.0.0.1: icmp_req=1 ttl=64 time=91.2 ms

64 bytes from 10.0.0.1: icmp_req=2 ttl=64 time=0.256 ms

64 bytes from 10.0.0.1: icmp_req=3 ttl=64 time=0.057 ms

64 bytes from 10.0.0.1: icmp_req=4 ttl=64 time=0.073 ms

...

pingを送信し続けたまま、スイッチs1のフローエントリを確認します。

Node: s1:

# ovs-ofctl -O openflow13 dump-flows s1

OFPST_FLOW reply (OF1.3) (xid=0x2):

cookie=0x0, duration=99.765s, table=0, n_packets=4, n_bytes=496, idle_timeout=90, send_flow_rem priority=65535,in_port=2,dl_src=00:00:00:00:00:12,dl_type=0x8809 actions=CONTROLLER:65509

cookie=0x0, duration=99.761s, table=0, n_packets=4, n_bytes=496, idle_timeout=90, send_flow_rem priority=65535,in_port=1,dl_src=00:00:00:00:00:11,dl_type=0x8809 actions=CONTROLLER:65509

cookie=0x0, duration=110.761s, table=0, n_packets=10, n_bytes=696, priority=0 actions=CONTROLLER:65535

cookie=0x0, duration=80.974s, table=0, n_packets=82, n_bytes=7924, priority=1,in_port=3,dl_dst=02:01:02:03:04:08 actions=output:1

cookie=0x0, duration=2.677s, table=0, n_packets=2, n_bytes=196, priority=1,in_port=2,dl_dst=00:00:00:00:00:23 actions=output:4

cookie=0x0, duration=2.675s, table=0, n_packets=1, n_bytes=98, priority=1,in_port=4,dl_dst=02:01:02:03:04:08 actions=output:2

cookie=0x0, duration=80.977s, table=0, n_packets=83, n_bytes=8022, priority=1,in_port=1,dl_dst=00:00:00:00:00:22 actions=output:3

先ほど確認した時点から、2つのフローエントリが追加されています。durationの値が小さい5番目と6番目のエントリです。

それぞれ、

- 2番ポート(s1-eth2)からh3宛のパケットを受信したら4番ポート(s1-eth4)から出力する

- 4番ポート(s1-eth4、つまりh3の対向インターフェース)からh1のbond0宛のパケットを受信したら2番ポート(s1-eth2)から出力する

というフローエントリです。h3とh1の間のの通信にはs1-eth2が使用されていることがわかります。

もちろんホストh4からホストh1に対しても、pingを実行出来ます。これまでと同様に新たなフローエントリが登録され、h4とh1の間の通信にはs1-eth1が使用されます。

| 宛先ホスト | 使用ポート |

|---|---|

| h2 | 1 |

| h3 | 2 |

| h4 | 1 |

以上のように、通信に応じて複数リンクを使い分ける様子を確認できました。

耐障害性の向上¶

次に、リンク・アグリゲーションによる耐障害性の向上を確認します。現在の状況は、h2とh4がh1と通信する際にはs1-eth2を、h3がh1と通信する際にはs1-eth1を使用しています。

ここで、s1-eth1の対向インターフェースであるh1-eth0をリンク・アグリゲーションのグループから離脱させます。

Node: h1:

# ip link set h1-eth0 nomaster

h1-eth0が停止したことにより、ホストh3からホストh1へのpingが疎通不可能になります。無通信監視時間の90秒が経過すると、コントローラの動作ログに次のようなメッセージが出力されます。

Node: c0:

...

[LACP][INFO] SW=0000000000000001 PORT=1 LACP received.

[LACP][INFO] SW=0000000000000001 PORT=1 LACP sent.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP received.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP sent.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP received.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP sent.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP received.

[LACP][INFO] SW=0000000000000001 PORT=2 LACP sent.

[LACP][INFO] SW=0000000000000001 PORT=1 LACP exchange timeout has occurred.

slave state changed port: 1 enabled: False

...

「LACP exchange timeout has occurred.」は無通信監視時間に達したことを表します。ここでは、学習したMACアドレスと転送用のフローエントリをすべて削除することで、スイッチを起動直後の状態に戻します。

新たな通信が発生すれば、新たにMACアドレスを学習し、生きているリンクのみを利用したフローエントリが再び登録されます。

ホストh3とホストh1の間も新たなフローエントリが登録され、

Node: s1:

# ovs-ofctl -O openflow13 dump-flows s1

OFPST_FLOW reply (OF1.3) (xid=0x2):

cookie=0x0, duration=364.265s, table=0, n_packets=13, n_bytes=1612, idle_timeout=90, send_flow_rem priority=65535,in_port=2,dl_src=00:00:00:00:00:12,dl_type=0x8809 actions=CONTROLLER:65509

cookie=0x0, duration=374.521s, table=0, n_packets=25, n_bytes=1830, priority=0 actions=CONTROLLER:65535

cookie=0x0, duration=5.738s, table=0, n_packets=5, n_bytes=490, priority=1,in_port=3,dl_dst=02:01:02:03:04:08 actions=output:2

cookie=0x0, duration=6.279s, table=0, n_packets=5, n_bytes=490, priority=1,in_port=2,dl_dst=00:00:00:00:00:23 actions=output:5

cookie=0x0, duration=6.281s, table=0, n_packets=5, n_bytes=490, priority=1,in_port=5,dl_dst=02:01:02:03:04:08 actions=output:2

cookie=0x0, duration=5.506s, table=0, n_packets=5, n_bytes=434, priority=1,in_port=4,dl_dst=02:01:02:03:04:08 actions=output:2

cookie=0x0, duration=5.736s, table=0, n_packets=5, n_bytes=490, priority=1,in_port=2,dl_dst=00:00:00:00:00:21 actions=output:3

cookie=0x0, duration=6.504s, table=0, n_packets=6, n_bytes=532, priority=1,in_port=2,dl_dst=00:00:00:00:00:22 actions=output:4

ホストh3で停止していたpingが再開します。

Node: h3:

...

64 bytes from 10.0.0.1: icmp_req=144 ttl=64 time=0.193 ms

64 bytes from 10.0.0.1: icmp_req=145 ttl=64 time=0.081 ms

64 bytes from 10.0.0.1: icmp_req=146 ttl=64 time=0.095 ms

64 bytes from 10.0.0.1: icmp_req=237 ttl=64 time=44.1 ms

64 bytes from 10.0.0.1: icmp_req=238 ttl=64 time=2.52 ms

64 bytes from 10.0.0.1: icmp_req=239 ttl=64 time=0.371 ms

64 bytes from 10.0.0.1: icmp_req=240 ttl=64 time=0.103 ms

64 bytes from 10.0.0.1: icmp_req=241 ttl=64 time=0.067 ms

...

以上のように、一部のリンクに故障が発生した場合でも、他のリンクを用いて自動的に復旧できることが確認できました。

Ryuによるリンク・アグリゲーション機能の実装¶

OpenFlowを用いてどのようにリンク・アグリゲーション機能を実現しているかを見ていきます。

LACPを用いたリンク・アグリゲーションでは「LACPデータユニットの交換が正常に行われている間は当該物理インターフェースは有効」「LACPデータユニットの交換が途絶えたら当該物理インターフェースは無効」という振る舞いをします。物理インターフェースが無効ということは、そのインターフェースを使用するフローエントリが存在しないということでもあります。従って、

- LACPデータユニットを受信したら応答を作成して送信する

- LACPデータユニットが一定時間受信できなかったら当該物理インターフェースを使用するフローエントリを削除し、以降そのインターフェースを使用するフローエントリを登録しない

- 無効とされた物理インターフェースでLACPデータユニットを受信した場合、当該インターフェースを再度有効化する

- LACPデータユニット以外のパケットは「スイッチングハブ」と同様に学習・転送する

という処理を実装すれば、リンク・アグリゲーションの基本的な動作が可能となります。LACPに関わる部分とそうでない部分が明確に分かれているので、LACPに関わる部分をLACPライブラリとして切り出し、そうでない部分は「スイッチングハブ」のスイッチングハブを拡張するかたちで実装します。

LACPデータユニット受信時の応答作成・送信はフローエントリだけでは実現不可能であるため、Packet-Inメッセージを使用してOpenFlowコントローラ側で処理を行います。

注釈

LACPデータユニットを交換する物理インターフェースは、その役割によってACTIVEとPASSIVEに分類されます。ACTIVEは一定時間ごとにLACPデータユニットを送信し、疎通を能動的に確認します。PASSIVEはACTIVEから送信されたLACPデータユニットを受信した際に応答を返すことにより、疎通を受動的に確認します。

Ryuのリンク・アグリゲーション・アプリケーションは、PASSIVEモードのみ実装しています。

一定時間LACPデータユニットを受信しなかった場合に当該物理インターフェースを無効にする、という処理は、LACPデータユニットをPacket-Inさせるフローエントリにidle_timeoutを設定し、時間切れの際にFlowRemovedメッセージを送信させることにより、OpenFlowコントローラで当該インターフェースが無効になった際の対処を行うことができます。

無効となったインターフェースでLACPデータユニットの交換が再開された場合の処理は、LACPデータユニット受信時のPacket-Inメッセージのハンドラで当該インターフェースの有効/無効状態を判別・変更することで実現します。

物理インターフェースが無効となったとき、OpenFlowコントローラの処理としては「当該インターフェースを使用するフローエントリを削除する」だけでよさそうに思えますが、それでは不充分です。

たとえば3つの物理インターフェースをグループ化して使用している論理インターフェースがあり、振り分けロジックが「有効なインターフェース数によるMACアドレスの剰余」となっている場合を仮定します。

| インターフェース1 | インターフェース2 | インターフェース3 |

|---|---|---|

| MACアドレスの剰余:0 | MACアドレスの剰余:1 | MACアドレスの剰余:2 |

そして、各物理インターフェースを使用するフローエントリが以下のように3つずつ登録されていたとします。

| インターフェース1 | インターフェース2 | インターフェース3 |

|---|---|---|

| 宛先:00:00:00:00:00:00 | 宛先:00:00:00:00:00:01 | 宛先:00:00:00:00:00:02 |

| 宛先:00:00:00:00:00:03 | 宛先:00:00:00:00:00:04 | 宛先:00:00:00:00:00:05 |

| 宛先:00:00:00:00:00:06 | 宛先:00:00:00:00:00:07 | 宛先:00:00:00:00:00:08 |

ここでインターフェース1が無効になった場合、「有効なインターフェース数によるMACアドレスの剰余」という振り分けロジックに従うと、次のように振り分けられなければなりません。

| インターフェース1 | インターフェース2 | インターフェース3 |

|---|---|---|

| 無効 | MACアドレスの剰余:0 | MACアドレスの剰余:1 |

| インターフェース1 | インターフェース2 | インターフェース3 |

|---|---|---|

| 宛先:00:00:00:00:00:00 | 宛先:00:00:00:00:00:01 | |

| 宛先:00:00:00:00:00:02 | 宛先:00:00:00:00:00:03 | |

| 宛先:00:00:00:00:00:04 | 宛先:00:00:00:00:00:05 | |

| 宛先:00:00:00:00:00:06 | 宛先:00:00:00:00:00:07 | |

| 宛先:00:00:00:00:00:08 |

インターフェース1を使用していたフローエントリだけではなく、インターフェース2やインターフェース3のフローエントリも書き換える必要があることがわかります。これは物理インターフェースが無効になったときだけでなく、有効になったときも同様です。

従って、ある物理インターフェースの有効/無効状態が変更された場合の処理は、当該物理インターフェースが所属する論理インターフェースに含まれるすべての物理インターフェースを使用するフローエントリを削除する、としています。

注釈

振り分けロジックについては仕様で定められておらず、各機器の実装に委ねられています。Ryuのリンク・アグリゲーション・アプリケーションでは独自の振り分け処理を行わず、対向装置によって振り分けられた経路を使用しています。

ここでは、次のような機能を実装します。

LACPライブラリ

- LACPデータユニットを受信したら応答を作成して送信する

- LACPデータユニットの受信が途絶えたら、対応する物理インターフェースを無効とみなし、スイッチングハブに通知する

- LACPデータユニットの受信が再開されたら、対応する物理インターフェースを有効とみなし、スイッチングハブに通知する

スイッチングハブ

- LACPライブラリからの通知を受け、初期化が必要なフローエントリを削除する

- LACPデータユニット以外のパケットは従来どおり学習・転送する

LACPライブラリおよびスイッチングハブのソースコードは、Ryuのソースツリーにあります。

ryu/lib/lacplib.py

ryu/app/simple_switch_lacp_13.py

LACPライブラリの実装¶

以降の節で、前述の機能がLACPライブラリにおいてどのように実装されているかを見ていきます。なお、引用されているソースは抜粋です。全体像については実際のソースをご参照ください。

論理インターフェースの作成¶

リンク・アグリゲーション機能を使用するには、どのネットワーク機器においてどのインターフェースをどのグループとして束ねるのかという設定を事前に行っておく必要があります。LACPライブラリでは、以下のメソッドでこの設定を行います。

def add(self, dpid, ports):

"""add a setting of a bonding i/f.

'add' method takes the corresponding args in this order.

========= =====================================================

Attribute Description

========= =====================================================

dpid datapath id.

ports a list of integer values that means the ports face

with the slave i/fs.

========= =====================================================

if you want to use multi LAG, call 'add' method more than once.

"""

assert isinstance(ports, list)

assert len(ports) >= 2

ifs = {}

for port in ports:

ifs[port] = {'enabled': False, 'timeout': 0}

bond = {dpid: ifs}

self._bonds.append(bond)

引数の内容は以下のとおりです。

dpid

OpenFlowスイッチのデータパスIDを指定します。

ports

グループ化したいポート番号のリストを指定します。

このメソッドを呼び出すことにより、LACPライブラリは指定されたデータパスIDのOpenFlowスイッチの指定されたポートをひとつのグループとみなします。複数のグループを作成したい場合は繰り返しadd()メソッドを呼び出します。なお、論理インターフェースに割り当てられるMACアドレスは、OpenFlowスイッチの持つLOCALポートと同じものが自動的に使用されます。

ちなみに

OpenFlowスイッチの中には、スイッチ自身の機能としてリンク・アグリゲーション機能を提供しているものもあります(Open vSwitchなど)。ここではそうしたスイッチ独自の機能は使用せず、OpenFlowコントローラによる制御によってリンク・アグリゲーション機能を実現します。

Packet-In処理¶

「スイッチングハブ」は、宛先のMACアドレスが未学習の場合、受信したパケットをフラッディングします。LACPデータユニットは隣接するネットワーク機器間でのみ交換されるべきもので、他の機器に転送してしまうとリンク・アグリゲーション機能が正しく動作しません。そこで、「Packet-Inで受信したパケットがLACPデータユニットであれば横取りし、LACPデータユニット以外のパケットであればスイッチングハブの動作に委ねる」という処理を行い、スイッチングハブにはLACPデータユニットを見せないようにします。

@set_ev_cls(ofp_event.EventOFPPacketIn, MAIN_DISPATCHER)

def packet_in_handler(self, evt):

"""PacketIn event handler. when the received packet was LACP,

proceed it. otherwise, send a event."""

req_pkt = packet.Packet(evt.msg.data)

if slow.lacp in req_pkt:

(req_lacp, ) = req_pkt.get_protocols(slow.lacp)

(req_eth, ) = req_pkt.get_protocols(ethernet.ethernet)

self._do_lacp(req_lacp, req_eth.src, evt.msg)

else:

self.send_event_to_observers(EventPacketIn(evt.msg))

イベントハンドラ自体は「スイッチングハブ」と同様です。受信したメッセージにLACPデータユニットが含まれているかどうかで処理を分岐させています。

LACPデータユニットが含まれていた場合はLACPライブラリのLACPデータユニット受信処理を行います。LACPデータユニットが含まれていなかった場合、send_event_to_observers()というメソッドを呼んでいます。これはryu.base.app_manager.RyuAppクラスで定義されている、イベントを送信するためのメソッドです。

「スイッチングハブ」ではRyuで定義されたOpenFlowメッセージ受信イベントについて触れましたが、ユーザが独自にイベントを定義することもできます。上記ソースで送信しているEventPacketInというイベントは、LACPライブラリ内で作成したユーザ定義イベントです。

class EventPacketIn(event.EventBase):

"""a PacketIn event class using except LACP."""

def __init__(self, msg):

"""initialization."""

super(EventPacketIn, self).__init__()

self.msg = msg

ユーザ定義イベントは、ryu.controller.event.EventBaseクラスを継承して作成します。イベントクラスに内包するデータに制限はありません。EventPacketInクラスでは、Packet-Inメッセージで受信したryu.ofproto.OFPPacketInインスタンスをそのまま使用しています。

ユーザ定義イベントの受信方法については後述します。

ポートの有効/無効状態変更に伴う処理¶

LACPライブラリのLACPデータユニット受信処理は、以下の処理からなっています。

- LACPデータユニットを受信したポートが無効状態であれば有効状態に変更し、状態が変更したことをイベントで通知します。

- 無通信タイムアウトの待機時間が変更された場合、LACPデータユニット受信時にPacket-Inを送信するフローエントリを再登録します。

- 受信したLACPデータユニットに対する応答を作成し、送信します。

2.の処理については後述の「LACPデータユニットをPacket-Inさせるフローエントリの登録」で、3.の処理については後述の「LACPデータユニットの送受信処理」で、それぞれ説明します。ここでは1.の処理について説明します。

def _do_lacp(self, req_lacp, src, msg):

# ...

# when LACP arrived at disabled port, update the status of

# the slave i/f to enabled, and send a event.

if not self._get_slave_enabled(dpid, port):

self.logger.info(

"SW=%s PORT=%d the slave i/f has just been up.",

dpid_to_str(dpid), port)

self._set_slave_enabled(dpid, port, True)

self.send_event_to_observers(

EventSlaveStateChanged(datapath, port, True))

# ...

_get_slave_enabled()メソッドは、指定したスイッチの指定したポートが有効か否かを取得します。_set_slave_enabled()メソッドは、指定したスイッチの指定したポートの有効/無効状態を設定します。

上記のソースでは、無効状態のポートでLACPデータユニットを受信した場合、ポートの状態が変更されたということを示すEventSlaveStateChangedというユーザ定義イベントを送信しています。

class EventSlaveStateChanged(event.EventBase):

"""a event class that notifies the changes of the statuses of the

slave i/fs."""

def __init__(self, datapath, port, enabled):

"""initialization."""

super(EventSlaveStateChanged, self).__init__()

self.datapath = datapath

self.port = port

self.enabled = enabled

EventSlaveStateChangedイベントは、ポートが有効化したときの他に、ポートが無効化したときにも送信されます。無効化したときの処理は「FlowRemovedメッセージの受信処理」で実装されています。

EventSlaveStateChangedクラスには以下の情報が含まれます。

- ポートの有効/無効状態変更が発生したOpenFlowスイッチ

- 有効/無効状態変更が発生したポート番号

- 変更後の状態

LACPデータユニットをPacket-Inさせるフローエントリの登録¶

LACPデータユニットの交換間隔には、FAST(1秒ごと)とSLOW(30秒ごと)の2種類が定義されています。リンク・アグリゲーションの仕様では、交換間隔の3倍の時間無通信状態が続いた場合、そのインターフェースはリンク・アグリゲーションのグループから除外され、パケットの転送には使用されなくなります。

LACPライブラリでは、LACPデータユニット受信時にPacket-Inさせるフローエントリに対し、交換間隔の3倍の時間(SHORT_TIMEOUT_TIMEは3秒、LONG_TIMEOUT_TIMEは90秒)をidle_timeoutとして設定することにより、無通信の監視を行っています。

交換間隔が変更された場合、idle_timeoutの時間も再設定する必要があるため、LACPライブラリでは以下のような実装をしています。

def _do_lacp(self, req_lacp, src, msg):

# ...

# set the idle_timeout time using the actor state of the

# received packet.

if req_lacp.LACP_STATE_SHORT_TIMEOUT == \

req_lacp.actor_state_timeout:

idle_timeout = req_lacp.SHORT_TIMEOUT_TIME

else:

idle_timeout = req_lacp.LONG_TIMEOUT_TIME

# when the timeout time has changed, update the timeout time of

# the slave i/f and re-enter a flow entry for the packet from

# the slave i/f with idle_timeout.

if idle_timeout != self._get_slave_timeout(dpid, port):

self.logger.info(

"SW=%s PORT=%d the timeout time has changed.",

dpid_to_str(dpid), port)

self._set_slave_timeout(dpid, port, idle_timeout)

func = self._add_flow.get(ofproto.OFP_VERSION)

assert func

func(src, port, idle_timeout, datapath)

# ...

_get_slave_timeout()メソッドは、指定したスイッチの指定したポートにおける現在のidle_timeout値を取得します。_set_slave_timeout()メソッドは、指定したスイッチの指定したポートにおけるidle_timeout値を登録します。初期状態およびリンク・アグリゲーション・グループから除外された場合にはidle_timeout値は0に設定されているため、新たにLACPデータユニットを受信した場合、交換間隔がどちらであってもフローエントリを登録します。

使用するOpenFlowのバージョンによりOFPFlowModクラスのコンストラクタの引数が異なるため、バージョンに応じたフローエントリ登録メソッドを取得しています。以下はOpenFlow 1.2以降で使用するフローエントリ登録メソッドです。

def _add_flow_v1_2(self, src, port, timeout, datapath):

"""enter a flow entry for the packet from the slave i/f

with idle_timeout. for OpenFlow ver1.2 and ver1.3."""

ofproto = datapath.ofproto

parser = datapath.ofproto_parser

match = parser.OFPMatch(

in_port=port, eth_src=src, eth_type=ether.ETH_TYPE_SLOW)

actions = [parser.OFPActionOutput(

ofproto.OFPP_CONTROLLER, ofproto.OFPCML_MAX)]

inst = [parser.OFPInstructionActions(

ofproto.OFPIT_APPLY_ACTIONS, actions)]

mod = parser.OFPFlowMod(

datapath=datapath, command=ofproto.OFPFC_ADD,

idle_timeout=timeout, priority=65535,

flags=ofproto.OFPFF_SEND_FLOW_REM, match=match,

instructions=inst)

datapath.send_msg(mod)

上記ソースで、「対向インターフェースからLACPデータユニットを受信した場合はPacket-Inする」というフローエントリを、無通信監視時間つき最高優先度で設定しています。

LACPデータユニットの送受信処理¶

LACPデータユニット受信時、「ポートの有効/無効状態変更に伴う処理」や「LACPデータユニットをPacket-Inさせるフローエントリの登録」を行った後、応答用のLACPデータユニットを作成し、送信します。

def _do_lacp(self, req_lacp, src, msg):

# ...

# create a response packet.

res_pkt = self._create_response(datapath, port, req_lacp)

# packet-out the response packet.

out_port = ofproto.OFPP_IN_PORT

actions = [parser.OFPActionOutput(out_port)]

out = datapath.ofproto_parser.OFPPacketOut(

datapath=datapath, buffer_id=ofproto.OFP_NO_BUFFER,

data=res_pkt.data, in_port=port, actions=actions)

datapath.send_msg(out)

上記ソースで呼び出されている_create_response()メソッドは応答用パケット作成処理です。その中で呼び出されている_create_lacp()メソッドで応答用のLACPデータユニットを作成しています。作成した応答用パケットは、LACPデータユニットを受信したポートからPacket-Outさせます。

LACPデータユニットには送信側(Actor)の情報と受信側(Partner)の情報を設定します。受信したLACPデータユニットの送信側情報には対向インターフェースの情報が記載されているので、OpenFlowスイッチから応答を返すときにはそれを受信側情報として設定します。

@set_ev_cls(ofp_event.EventOFPFlowRemoved, MAIN_DISPATCHER)

def _create_lacp(self, datapath, port, req):

"""create a LACP packet."""

actor_system = datapath.ports[datapath.ofproto.OFPP_LOCAL].hw_addr

res = slow.lacp(

actor_system_priority=0xffff,

actor_system=actor_system,

actor_key=req.actor_key,

actor_port_priority=0xff,

actor_port=port,

actor_state_activity=req.LACP_STATE_PASSIVE,

actor_state_timeout=req.actor_state_timeout,

actor_state_aggregation=req.actor_state_aggregation,

actor_state_synchronization=req.actor_state_synchronization,

actor_state_collecting=req.actor_state_collecting,

actor_state_distributing=req.actor_state_distributing,

actor_state_defaulted=req.LACP_STATE_OPERATIONAL_PARTNER,

actor_state_expired=req.LACP_STATE_NOT_EXPIRED,

partner_system_priority=req.actor_system_priority,

partner_system=req.actor_system,

partner_key=req.actor_key,

partner_port_priority=req.actor_port_priority,

partner_port=req.actor_port,

partner_state_activity=req.actor_state_activity,

partner_state_timeout=req.actor_state_timeout,

partner_state_aggregation=req.actor_state_aggregation,

partner_state_synchronization=req.actor_state_synchronization,

partner_state_collecting=req.actor_state_collecting,

partner_state_distributing=req.actor_state_distributing,

partner_state_defaulted=req.actor_state_defaulted,

partner_state_expired=req.actor_state_expired,

collector_max_delay=0)

self.logger.info("SW=%s PORT=%d LACP sent.",

dpid_to_str(datapath.id), port)

self.logger.debug(str(res))

return res

FlowRemovedメッセージの受信処理¶

指定された時間の間LACPデータユニットの交換が行われなかった場合、OpenFlowスイッチはFlowRemovedメッセージをOpenFlowコントローラに送信します。

@set_ev_cls(ofp_event.EventOFPFlowRemoved, MAIN_DISPATCHER)

def flow_removed_handler(self, evt):

"""FlowRemoved event handler. when the removed flow entry was

for LACP, set the status of the slave i/f to disabled, and

send a event."""

msg = evt.msg

datapath = msg.datapath

ofproto = datapath.ofproto

dpid = datapath.id

match = msg.match

if ofproto.OFP_VERSION == ofproto_v1_0.OFP_VERSION:

port = match.in_port

dl_type = match.dl_type

else:

port = match['in_port']

dl_type = match['eth_type']

if ether.ETH_TYPE_SLOW != dl_type:

return

self.logger.info(

"SW=%s PORT=%d LACP exchange timeout has occurred.",

dpid_to_str(dpid), port)

self._set_slave_enabled(dpid, port, False)

self._set_slave_timeout(dpid, port, 0)

self.send_event_to_observers(

EventSlaveStateChanged(datapath, port, False))

FlowRemovedメッセージを受信すると、OpenFlowコントローラは_set_slave_enabled()メソッドを使用してポートの無効状態を設定し、_set_slave_timeout()メソッドを使用してidle_timeout値を0に設定し、send_event_to_observers()メソッドを使用してEventSlaveStateChangedイベントを送信します。

アプリケーションの実装¶

「Ryuアプリケーションの実行」に示したOpenFlow 1.3対応のリンク・アグリゲーション・アプリケーション (simple_switch_lacp_13.py) と、「スイッチングハブ」のスイッチングハブとの差異を順に説明していきます。

「_CONTEXTS」の設定¶

ryu.base.app_manager.RyuAppを継承したRyuアプリケーションは、「_CONTEXTS」ディクショナリに他のRyuアプリケーションを設定することにより、他のアプリケーションを別スレッドで起動させることができます。ここではLACPライブラリのLacpLibクラスを「lacplib」という名前で「_CONTEXTS」に設定しています。

from ryu.lib import lacplib

# ...

class SimpleSwitchLacp13(simple_switch_13.SimpleSwitch13):

OFP_VERSIONS = [ofproto_v1_3.OFP_VERSION]

_CONTEXTS = {'lacplib': lacplib.LacpLib}

# ...

「_CONTEXTS」に設定したアプリケーションは、__init__()メソッドのkwargsからインスタンスを取得することができます。

def __init__(self, *args, **kwargs):

super(SimpleSwitchLacp13, self).__init__(*args, **kwargs)

self.mac_to_port = {}

self._lacp = kwargs['lacplib']

# ...

ライブラリの初期設定¶

「_CONTEXTS」に設定したLACPライブラリの初期設定を行います。初期設定にはLACPライブラリの提供するadd()メソッドを実行します。ここでは以下の値を設定します。

| パラメータ | 値 | 説明 |

|---|---|---|

| dpid | str_to_dpid(‘0000000000000001’) | データパスID |

| ports | [1, 2] | グループ化するポートのリスト |

この設定により、データパスID「0000000000000001」のOpenFlowスイッチのポート1とポート2がひとつのリンク・アグリゲーション・グループとして動作します。

def __init__(self, *args, **kwargs):

# ...

self._lacp = kwargs['lacplib']

self._lacp.add(

dpid=str_to_dpid('0000000000000001'), ports=[1, 2])

ユーザ定義イベントの受信方法¶

LACPライブラリの実装で説明したとおり、LACPライブラリはLACPデータユニットの含まれないPacket-InメッセージをEventPacketInというユーザ定義イベントとして送信します。ユーザ定義イベントのイベントハンドラも、Ryuが提供するイベントハンドラと同じようにryu.controller.handler.set_ev_clsデコレータで装飾します。

@set_ev_cls(lacplib.EventPacketIn, MAIN_DISPATCHER)

def _packet_in_handler(self, ev):

msg = ev.msg

datapath = msg.datapath

ofproto = datapath.ofproto

parser = datapath.ofproto_parser

in_port = msg.match['in_port']

# ...

また、LACPライブラリはポートの有効/無効状態が変更されるとEventSlaveStateChangedイベントを送信しますので、こちらもイベントハンドラを作成しておきます。

@set_ev_cls(lacplib.EventSlaveStateChanged, MAIN_DISPATCHER)

def _slave_state_changed_handler(self, ev):

datapath = ev.datapath

dpid = datapath.id

port_no = ev.port

enabled = ev.enabled

self.logger.info("slave state changed port: %d enabled: %s",

port_no, enabled)

if dpid in self.mac_to_port:

for mac in self.mac_to_port[dpid]:

match = datapath.ofproto_parser.OFPMatch(eth_dst=mac)

self.del_flow(datapath, match)

del self.mac_to_port[dpid]

self.mac_to_port.setdefault(dpid, {})

本節の冒頭で説明したとおり、ポートの有効/無効状態が変更されると、論理インターフェースを通過するパケットが実際に使用する物理インターフェースが変更になる可能性があります。そのため、登録されているフローエントリを全て削除しています。

def del_flow(self, datapath, match):

ofproto = datapath.ofproto

parser = datapath.ofproto_parser

mod = parser.OFPFlowMod(datapath=datapath,

command=ofproto.OFPFC_DELETE,

out_port=ofproto.OFPP_ANY,

out_group=ofproto.OFPG_ANY,

match=match)

datapath.send_msg(mod)

フローエントリの削除はOFPFlowModクラスのインスタンスで行います。

以上のように、リンク・アグリゲーション機能を提供するライブラリと、ライブラリを利用するアプリケーションによって、リンク・アグリゲーション機能を持つスイッチングハブのアプリケーションを実現しています。

まとめ¶

本章では、リンク・アグリゲーションライブラリの利用を題材として、以下の項目について説明しました。

- 「_CONTEXTS」を用いたライブラリの使用方法

- ユーザ定義イベントの定義方法とイベントトリガーの発生方法